L'irragionevole scalabilità dell'IA

Se spremi abbastanza a lungo, puoi produrre più "succo di intelligenza"

Voglio illustrare perché la potenza dell’intelligenza artificiale nelle architetture moderne sia così inaspettata, addirittura irragionevole, utilizzando una serie di esempi che chiamo “disanalogie”, analogie paradossali che mostrano come ciò che ci aspettiamo nel mondo fisico non corrisponda affatto a quello che avviene nel mondo dell’intelligenza artificiale.

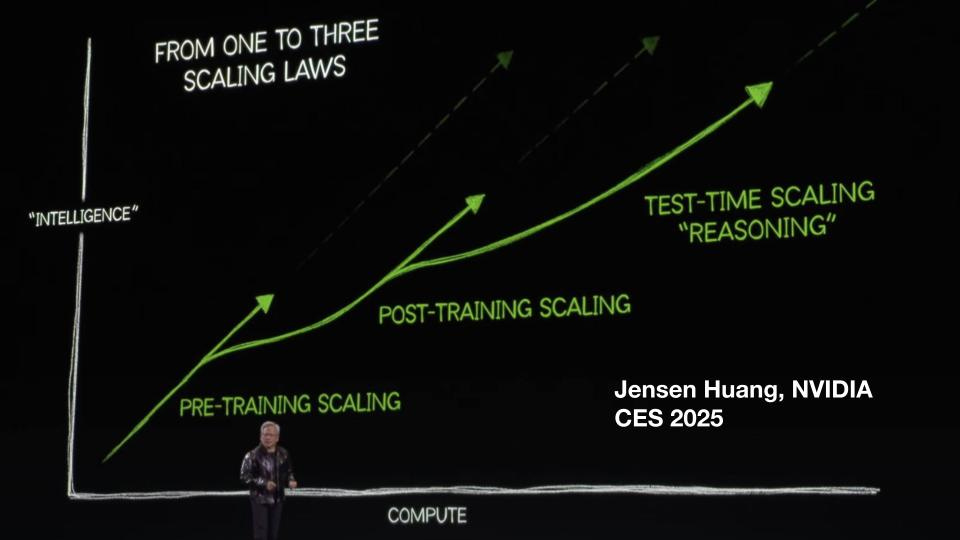

Parto dalle slide che Jensen Huang, fondatore e CEO di NVIDIA, ha presentato al Consumer Electronics Show nel gennaio 2025. In questa slide, in particolare, mostra come le leggi di scalabilità si applichino a ondate successive in diverse fasi dello sviluppo e dell’applicazione dei motori di intelligenza artificiale moderni. Ognuna di queste leggi sviluppa una potenza esponenziale, ed è l’inviluppo di queste varie leggi di scalabilità che osserviamo nelle applicazioni, sempre più potenti, che utilizziamo ogni giorno.

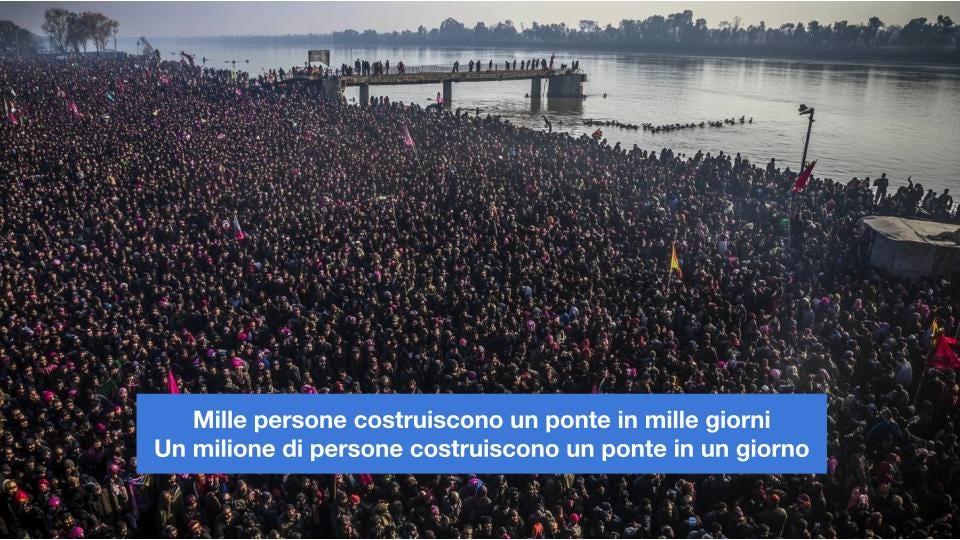

Cosa succede quando addestriamo il motore? Naturalmente, ci aspetteremmo di massimizzare la potenza dell’intelligenza artificiale come faremmo nella costruzione di un ponte. Se ci vogliono mille persone per costruire un ponte in mille giorni, è ragionevole forse aspettarsi che un milione di persone realizzi quello stesso ponte in un solo giorno? Paradossale, vero? Eppure è quello che avviene nei sistemi di intelligenza artificiale.

Oppure, se vogliamo “spremere” il sistema per produrre intelligenza e continuiamo a spremere di più e di più, è un po’ come se spremessimo un limone che produce un certo volume di succo e decidessimo, no, spremiamolo più a lungo. E dopo dieci ore scopriamo che quell’unico limone ha prodotto mille litri di succo. È ciò che avviene nell’intelligenza artificiale, dove riusciamo a estrarre più “succo di intelligenza” addestrando più a lungo.

Quando il sistema è addestrato, viene bilanciato in modo che le sue caratteristiche permettano certe rese nelle diverse aree applicative. È poi possibile intervenire con quella che viene chiamata la modalità di fine tuning, cioè specializzare il modello in un’area particolare per mettere in evidenza capacità prima latenti ma non sufficientemente accessibili o sviluppate. È un po’ quello che vediamo tutti i giorni: dai una nuova mano di pittura alla tua macchina e, scintillante, questa si mette a volare. Giusto? La capacità latente della macchina, che nessuno presumeva, si manifesta: non solo è lucida, ma vola pure. Oppure, sapendo che stanno arrivando dieci nuovi ospiti a casa tua, non ti preoccupi perché tanto la casa sviluppa stanze che prima non c’erano, dove li puoi far accomodare. E se ne arrivano mille, va bene lo stesso.

Più recentemente, abbiamo cominciato a introdurre modelli che sono in grado di adattare il proprio comportamento non in fase di addestramento, non in fase di fine tuning, ma in fase di esecuzione, attraverso il dialogo stesso con gli utilizzatori, dove il sistema può essere invitato a riflettere su quello che fa, focalizzandosi di più. Magari è quello che succede quando decidi che, di fronte a un problema particolarmente complicato, la cosa giusta da fare sia bere mille tazzine di caffè, perché questo ti permetterà di focalizzarti meglio e di sostenere i ragionamenti necessari. E no, non è così che funziona il nostro cervello, la nostra fisiologia, ma è proprio ciò che avviene nei sistemi di intelligenza artificiale.

L’insieme, l’inviluppo di queste leggi di scalabilità inaspettate e irragionevoli, ma che continuiamo a osservare, rappresenta una generalizzazione della legge di Moore, una generalizzazione dell’approccio espresso e analizzato da Ray Kurzweil nella sua legge dei ritorni che accelerano. Ed è fantastico poterne approfittare. Come in passato chi diceva che la legge di Moore era morta si sbagliava, perché la creatività e la passione degli ingegneri in tutto il mondo le hanno permesso di continuare attraverso approcci sempre diversi e innovativi, così chi oggi sostiene che l’AI sia già finita, che questa ondata si stia esaurendo, non si rende conto che sta guardando una sola curva esponenziale invece di riconoscere il paradigma, l’inviluppo di curve che delineano l’innovazione che continueremo a esplorare.